Medida de la variabilidad conjunta

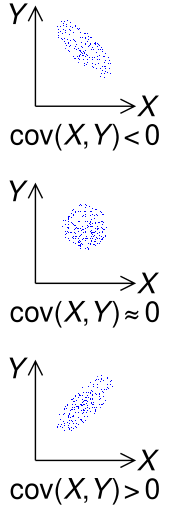

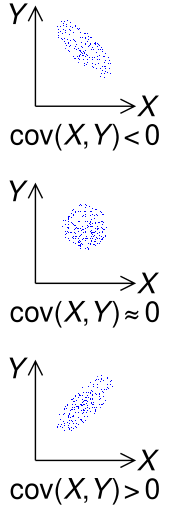

El signo de la covarianza de dos variables aleatorias

X e

Y

Este artículo trata sobre el grado en que las variables aleatorias varían de manera similar. Para otros usos, consulte

Covarianza (desambiguación) .

En teoría de probabilidad y estadística , la covarianza es una medida de la variabilidad conjunta de dos variables aleatorias . Si los valores mayores de una variable se corresponden principalmente con los valores mayores de la otra variable, y lo mismo ocurre con los valores menores (es decir, las variables tienden a mostrar un comportamiento similar), la covarianza es positiva. En el caso contrario, cuando los valores mayores de una variable corresponden principalmente a los valores menores de la otra (es decir, las variables tienden a mostrar un comportamiento opuesto), la covarianza es negativa. Por tanto, el signo de la covarianza muestra la tendencia en la relación lineal entre las variables. La magnitud de la covarianza no es fácil de interpretar porque no está normalizada y, por tanto, depende de las magnitudes de las variables. La versión normalizada de la covarianza , el coeficiente de correlación , sin embargo, muestra por su magnitud la fuerza de la relación lineal.

Se debe hacer una distinción entre (1) la covarianza de dos variables aleatorias, que es un parámetro poblacional que puede verse como una propiedad de la distribución de probabilidad conjunta , y (2) la covarianza muestral , que además de servir como descriptor de la muestra, también sirve como valor estimado del parámetro de población.

Definición

Durante dos distribuidas conjuntamente reales -valued variables aleatorias y con finitos segundos momentos , la covarianza se define como el valor esperado (o media) del producto de sus desviaciones con respecto a sus valores esperados individuales:

![{\ Displaystyle \ operatorname {cov} (X, Y) = \ operatorname {E} {{\ big [} (X- \ operatorname {E} [X]) (Y- \ operatorname {E} [Y]) { \grande ]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f98a8bf924edb41a8025b5ffaa1b255b4a6f48b9) |

|

( Ecuación 1 )

|

donde es el valor esperado de , también conocido como la media de . La covarianza también se denota a veces o , en analogía a la varianza . Al usar la propiedad de linealidad de las expectativas, esto se puede simplificar al valor esperado de su producto menos el producto de sus valores esperados:

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\ Displaystyle {\ begin {alineado} \ operatorname {cov} (X, Y) & = \ operatorname {E} \ left [\ left (X- \ operatorname {E} \ left [X \ right] \ right) \ left (Y- \ operatorname {E} \ left [Y \ right] \ right) \ right] \\ & = \ operatorname {E} \ left [XY-X \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [X \ right] Y + \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] \ right] \\ & = \ operatorname {E} \ left [XY \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] + \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] \\ & = \ operatorname {E} \ left [XY \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right], \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b82a8c24b0063ffd95d8624f460acaaacb2a99b3)

pero esta ecuación es susceptible de cancelación catastrófica (consulte la sección sobre cálculo numérico a continuación).

Las unidades de medida de la covarianza son las veces las de . Por el contrario, los coeficientes de correlación , que dependen de la covarianza, son una medida adimensional de dependencia lineal. (De hecho, los coeficientes de correlación pueden entenderse simplemente como una versión normalizada de la covarianza).

Definición de variables aleatorias complejas

La covarianza entre dos variables aleatorias complejas se define como

![{\ Displaystyle \ operatorname {cov} (Z, W) = \ operatorname {E} \ left [(Z- \ operatorname {E} [Z]) {\ overline {(W- \ operatorname {E} [W]) }} \ right] = \ operatorname {E} \ left [Z {\ overline {W}} \ right] - \ operatorname {E} [Z] \ operatorname {E} \ left [{\ overline {W}} \ Derecha]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc823fe25634365b1859a3ee206ca894203a9ee2)

Observe la compleja conjugación del segundo factor en la definición.

También se puede definir una pseudocovarianza relacionada .

Variables aleatorias discretas

Si el par de variables aleatorias (reales) puede tomar los valores de , con probabilidades iguales , entonces la covarianza se puede escribir de manera equivalente en términos de las medias y como

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\ Displaystyle \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5)

También se puede expresar de manera equivalente, sin referirse directamente a los medios, como

De manera más general, si hay posibles realizaciones de , a saber, pero con probabilidades posiblemente desiguales de , entonces la covarianza es

Ejemplo

Interpretación geométrica del ejemplo de covarianza. Cada cuboide es el cuadro delimitador de su punto (

x ,

y ,

f (

x ,

y )) y las medias

X e

Y (punto magenta). La covarianza es la suma de los volúmenes de los cuboides rojos menos los cuboides azules.

Suponga que y tiene la siguiente función de masa de probabilidad conjunta , en la que las seis celdas centrales dan las probabilidades conjuntas discretas de las seis realizaciones hipotéticas :

|

X

|

|

|

| 5

|

6

|

7

|

|

y

|

8

|

0

|

0.4

|

0,1

|

0,5

|

| 9

|

0,3

|

0

|

0,2

|

0,5

|

|

|

|

0,3

|

0.4

|

0,3

|

1

|

puede tomar tres valores (5, 6 y 7) mientras que puede tomar dos (8 y 9). Sus medios son y . Luego,

puede tomar tres valores (5, 6 y 7) mientras que puede tomar dos (8 y 9). Sus medios son y . Luego,

![{\ Displaystyle {\ begin {alineado} \ operatorname {cov} (X, Y) = {} & \ sigma _ {XY} = \ sum _ {(x, y) \ in S} f (x, y) \ izquierda (x- \ mu _ {X} \ derecha) \ izquierda (y- \ mu _ {Y} \ derecha) \\ [4pt] = {} & (0) (5-6) (8-8.5) + (0.4) (6-6) (8-8.5) + (0.1) (7-6) (8-8.5) + {} \\ [4pt] y (0.3) (5-6) (9-8.5) + (0) (6-6) (9-8.5) + (0.2) (7-6) (9-8.5) \\ [4pt] = {} & {- 0.1} \;. \ End {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8a80fa4db641ca7ddd6f7a3fee8620eed15321a7)

Propiedades

Covarianza consigo mismo

La varianza es un caso especial de covarianza en el que las dos variables son idénticas (es decir, en el que una variable siempre toma el mismo valor que la otra):

Covarianza de combinaciones lineales

Si , , , y son de valor real variables aleatorias y son constantes con valores reales, a continuación, los siguientes hechos son una consecuencia de la definición de covarianza:

Para una secuencia de variables aleatorias en valores reales y constantes , tenemos

Identidad de covarianza de Hoeffding

Una identidad útil para calcular la covarianza entre dos variables aleatorias es la identidad de covarianza de Hoeffding:

donde es la función de distribución acumulativa conjunta del vector aleatorio y son los marginales .

Falta de correlación e independencia

Las variables aleatorias cuya covarianza es cero se denominan no correlacionadas . De manera similar, los componentes de vectores aleatorios cuya matriz de covarianza es cero en cada entrada fuera de la diagonal principal también se denominan no correlacionados.

Si y son variables aleatorias independientes , entonces su covarianza es cero. Esto se sigue porque bajo la independencia,

![{\ Displaystyle \ operatorname {E} [XY] = \ operatorname {E} [X] \ cdot \ operatorname {E} [Y].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c0c2870ec57051083bd6262aa4069a2500dfda44)

Sin embargo, lo contrario no es generalmente cierto. Por ejemplo, déjelo distribuir uniformemente y déjelo . Claramente, y no son independientes, pero

![[-1,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)

![{\ displaystyle {\ begin {alineado} \ operatorname {cov} (X, Y) & = \ operatorname {cov} \ left (X, X ^ {2} \ right) \\ & = \ operatorname {E} \ left [X \ cdot X ^ {2} \ right] - \ operatorname {E} [X] \ cdot \ operatorname {E} \ left [X ^ {2} \ right] \\ & = \ operatorname {E} \ left [X ^ {3} \ right] - \ operatorname {E} [X] \ operatorname {E} \ left [X ^ {2} \ right] \\ & = 0-0 \ cdot \ operatorname {E} [X ^ {2}] \\ & = 0. \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/19b6f2d636d5ef9ba85b6350e49222109a28d665)

En este caso, la relación entre y no es lineal, mientras que la correlación y la covarianza son medidas de dependencia lineal entre dos variables aleatorias. Este ejemplo muestra que si dos variables aleatorias no están correlacionadas, eso no implica en general que sean independientes. Sin embargo, si dos variables están en forma conjunta distribuyen normalmente (pero no si son meramente individual distribuidos normalmente ), uncorrelatedness hace implicaría la independencia.

Relación con los productos internos

Muchas de las propiedades de la covarianza se pueden extraer elegantemente al observar que satisface propiedades similares a las de un producto interno :

-

bilineal : para constantes y variables aleatorias ,

- simétrico:

-

semidefinido positivo : para todas las variables aleatorias , e implica que es constante casi con seguridad .

De hecho, estas propiedades implican que la covarianza define un producto interno sobre el espacio vectorial cociente obtenido tomando el subespacio de variables aleatorias con segundo momento finito e identificando dos cualesquiera que difieran por una constante. (Esta identificación convierte la semidefinición positiva anterior en definición positiva.) Ese espacio vectorial cociente es isomorfo al subespacio de variables aleatorias con segundo momento finito y media cero; en ese subespacio, la covarianza es exactamente el producto interno L 2 de funciones de valor real en el espacio muestral.

Como resultado, para las variables aleatorias con varianza finita, la desigualdad

se mantiene a través de la desigualdad de Cauchy-Schwarz .

Prueba: Si , entonces se sostiene trivialmente. De lo contrario, deje que la variable aleatoria

Entonces tenemos

![{\ displaystyle {\ begin {align} 0 \ leq \ sigma ^ {2} (Z) & = \ operatorname {cov} \ left (X - {\ frac {\ operatorname {cov} (X, Y)} {\ sigma ^ {2} (Y)}} Y, \; X - {\ frac {\ operatorname {cov} (X, Y)} {\ sigma ^ {2} (Y)}} Y \ right) \\ [ 12pt] & = \ sigma ^ {2} (X) - {\ frac {(\ operatorname {cov} (X, Y)) ^ {2}} {\ sigma ^ {2} (Y)}}. \ End {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc8741ab12cb5943efe9d8dbfeb455517bc63347)

Calcular la covarianza de la muestra

Las covarianzas muestrales entre las variables basadas en las observaciones de cada una, extraídas de una población que de otro modo no se observaría, están dadas por la matriz con las entradas

![{\ Displaystyle \ textstyle {\ overline {\ mathbf {q}}} = \ left [q_ {jk} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb28ac928a2a379d039d27fb99d56dd21c1c027c)

que es una estimación de la covarianza entre variable y variable .

La media muestral y la matriz de covarianza muestral son estimaciones insesgadas de la media y la matriz de covarianza del vector aleatorio , un vector cuyo j- ésimo elemento es una de las variables aleatorias. La razón por la que la matriz de covarianza de la muestra tiene en el denominador en lugar de es esencialmente que la media de la población no se conoce y se reemplaza por la media de la muestra . Si se conoce la media de la población , la estimación análoga insesgada viene dada por

-

.

.

Generalizaciones

Matriz de covarianza automática de vectores aleatorios reales

Para un vector de variables aleatorias distribuidas conjuntamente con segundos momentos finitos, su matriz de auto-covarianza (también conocida como matriz de varianza-covarianza o simplemente matriz de covarianza ) (también denotada por o ) se define como

![{\ displaystyle {\ begin {alineado} \ operatorname {K} _ {\ mathbf {XX}} = \ operatorname {cov} (\ mathbf {X}, \ mathbf {X}) & = \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ mathrm {T}} \ right] \\ & = \ operatorname {E} \ left [\ mathbf {XX} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf {X}] \ operatorname {E} [\ mathbf {X}] ^ {\ mathrm {T}}. \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/15725714f72a46ffb0686bafdb209260b842ac39)

Sea un vector aleatorio con matriz de covarianza Σ , y sea A una matriz que puede actuar a la izquierda. La matriz de covarianza del producto matriz-vector AX es:

![{\ Displaystyle {\ begin {alineado} \ operatorname {cov} (\ mathbf {AX}, \ mathbf {AX}) & = \ operatorname {E} \ left [\ mathbf {AX (A} \ mathbf {X)} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf {AX}] \ operatorname {E} \ left [(\ mathbf {A} \ mathbf {X}) ^ {\ mathrm {T }} \ right] \\ & = \ operatorname {E} \ left [\ mathbf {AXX} ^ {\ mathrm {T}} \ mathbf {A} ^ {\ mathrm {T}} \ right] - \ operatorname { E} [\ mathbf {AX}] \ operatorname {E} \ left [\ mathbf {X} ^ {\ mathrm {T}} \ mathbf {A} ^ {\ mathrm {T}} \ right] \\ & = \ mathbf {A} \ operatorname {E} \ left [\ mathbf {XX} ^ {\ mathrm {T}} \ right] \ mathbf {A} ^ {\ mathrm {T}} - \ mathbf {A} \ operatorname {E} [\ mathbf {X}] \ operatorname {E} \ left [\ mathbf {X} ^ {\ mathrm {T}} \ right] \ mathbf {A} ^ {\ mathrm {T}} \\ & = \ mathbf {A} \ left (\ operatorname {E} \ left [\ mathbf {XX} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf {X}] \ operatorname {E } \ left [\ mathbf {X} ^ {\ mathrm {T}} \ right] \ right) \ mathbf {A} ^ {\ mathrm {T}} \\ & = \ mathbf {A} \ Sigma \ mathbf { A} ^ {\ mathrm {T}}. \ End {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c1b2123c32a8acefc209a4f69d571ee1197a8c59)

Este es un resultado directo de la linealidad de la expectativa y es útil cuando se aplica una transformación lineal , como una transformación de blanqueamiento , a un vector.

Matriz de covarianza cruzada de vectores aleatorios reales

Para vectores aleatorios reales y , la matriz de covarianza cruzada es igual a

![{\ Displaystyle {\ begin {alineado} \ operatorname {K} _ {\ mathbf {X} \ mathbf {Y}} = \ operatorname {cov} (\ mathbf {X}, \ mathbf {Y}) & = \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {Y} - \ operatorname {E} [\ mathbf {Y}]) ^ {\ mathrm {T}} \ right] \\ & = \ operatorname {E} \ left [\ mathbf {X} \ mathbf {Y} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf { X}] \ nombre del operador {E} [\ mathbf {Y}] ^ {\ mathrm {T}} \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99e6f5ef675f7bb826d04f206bd212d14632ab8c) |

|

( Ecuación 2 )

|

donde es la transpuesta del vector (o matriz) .

El -ésimo elemento de esta matriz es igual a la covarianza entre el i -ésimo componente escalar de y el j -ésimo componente escalar de . En particular, es la transposición de .

Computación numérica

Cuándo , la ecuación es propensa a una cancelación catastrófica si y no se calculan exactamente y, por lo tanto, debe evitarse en los programas de computadora cuando los datos no se han centrado antes. En este caso, deberían preferirse los algoritmos numéricamente estables .

![\ operatorname {E} [XY] \ approx \ operatorname {E} [X] \ operatorname {E} [Y]](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cc8091d0da21aa8f5a114797ba5113ddf534f69)

![{\ Displaystyle \ operatorname {cov} (X, Y) = \ operatorname {E} \ left [XY \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdf56a30f7ff1be354713f144bfd02ba949a77f4)

![{\ Displaystyle \ operatorname {E} \ left [XY \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/128f7734bafe2a92d25d3df5fbb614e1d22b2e45)

![{\ Displaystyle \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f05701ae57cc8e32cd812037d7ba5d3d433021d4)

La covarianza se denomina a veces una medida de "dependencia lineal" entre las dos variables aleatorias. Eso no significa lo mismo que en el contexto del álgebra lineal (ver dependencia lineal ). Cuando se normaliza la covarianza, se obtiene el coeficiente de correlación de Pearson , que da la bondad del ajuste para la mejor función lineal posible que describe la relación entre las variables. En este sentido, la covarianza es un indicador lineal de dependencia.

Aplicaciones

En genética y biología molecular

La covarianza es una medida importante en biología . Ciertas secuencias de ADN se conservan más que otras entre especies y, por lo tanto, para estudiar las estructuras secundarias y terciarias de las proteínas , o de las estructuras de ARN , las secuencias se comparan en especies estrechamente relacionadas. Si se encuentran cambios de secuencia o no se encuentran cambios en absoluto en el ARN no codificante (como el microARN ), se considera que las secuencias son necesarias para motivos estructurales comunes, como un bucle de ARN. En genética, la covarianza sirve como base para el cálculo de la Matriz de Relación Genética (GRM) (también conocida como matriz de parentesco), lo que permite la inferencia sobre la estructura de la población a partir de una muestra sin parientes cercanos conocidos, así como la inferencia sobre la estimación de la heredabilidad de rasgos complejos.

En la teoría de la evolución y la selección natural , la ecuación de Price describe cómo un rasgo genético cambia en frecuencia con el tiempo. La ecuación utiliza una covarianza entre un rasgo y la aptitud , para dar una descripción matemática de la evolución y la selección natural. Proporciona una forma de comprender los efectos que la transmisión genética y la selección natural tienen sobre la proporción de genes dentro de cada nueva generación de una población. La ecuación de Price fue derivada por George R. Price , para volver a derivar el trabajo de WD Hamilton sobre la selección de parentesco . Se han elaborado ejemplos de la ecuación de Price para varios casos evolutivos.

En economía financiera

Las covarianzas juegan un papel clave en la economía financiera , especialmente en la teoría moderna de carteras y en el modelo de precios de activos de capital . Las covarianzas entre los rendimientos de varios activos se utilizan para determinar, bajo ciertos supuestos, las cantidades relativas de diferentes activos que los inversores deberían (en un análisis normativo ) o se prevé que (en un análisis positivo ) opten por mantener en un contexto de diversificación .

En asimilación de datos meteorológicos y oceanográficos

La matriz de covarianza es importante para estimar las condiciones iniciales requeridas para ejecutar modelos de pronóstico del tiempo, un procedimiento conocido como asimilación de datos . La 'matriz de covarianza de error de pronóstico' se construye típicamente entre perturbaciones alrededor de un estado medio (ya sea un medio climatológico o de conjunto). La 'matriz de covarianza de errores de observación' se construye para representar la magnitud de los errores de observación combinados (en la diagonal) y los errores correlacionados entre las mediciones (fuera de la diagonal). Este es un ejemplo de su aplicación generalizada al filtrado de Kalman y la estimación de estado más general para sistemas que varían en el tiempo.

En micrometeorología

La técnica de covarianza de remolinos es una técnica clave de medición atmosférica donde la covarianza entre la desviación instantánea en la velocidad del viento vertical del valor medio y la desviación instantánea en la concentración de gas es la base para calcular los flujos turbulentos verticales.

En procesamiento de señales

La matriz de covarianza se utiliza para capturar la variabilidad espectral de una señal.

En estadística y procesamiento de imágenes

La matriz de covarianza se utiliza en el análisis de componentes principales para reducir la dimensionalidad de las características en el preprocesamiento de datos .

Ver también

Referencias

![{\ Displaystyle \ operatorname {cov} (X, Y) = \ operatorname {E} {{\ big [} (X- \ operatorname {E} [X]) (Y- \ operatorname {E} [Y]) { \grande ]}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f98a8bf924edb41a8025b5ffaa1b255b4a6f48b9)

![\ operatorname {E} [X]](https://wikimedia.org/api/rest_v1/media/math/render/svg/44dd294aa33c0865f58e2b1bdaf44ebe911dbf93)

![{\ Displaystyle {\ begin {alineado} \ operatorname {cov} (X, Y) & = \ operatorname {E} \ left [\ left (X- \ operatorname {E} \ left [X \ right] \ right) \ left (Y- \ operatorname {E} \ left [Y \ right] \ right) \ right] \\ & = \ operatorname {E} \ left [XY-X \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [X \ right] Y + \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] \ right] \\ & = \ operatorname {E} \ left [XY \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] + \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right] \\ & = \ operatorname {E} \ left [XY \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right], \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b82a8c24b0063ffd95d8624f460acaaacb2a99b3)

![{\ Displaystyle \ operatorname {cov} (Z, W) = \ operatorname {E} \ left [(Z- \ operatorname {E} [Z]) {\ overline {(W- \ operatorname {E} [W]) }} \ right] = \ operatorname {E} \ left [Z {\ overline {W}} \ right] - \ operatorname {E} [Z] \ operatorname {E} \ left [{\ overline {W}} \ Derecha]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cc823fe25634365b1859a3ee206ca894203a9ee2)

![{\ Displaystyle \ operatorname {E} [Y]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/639e8577c6faffc0471c7e123ead30970034e6d5)

![{\ Displaystyle {\ begin {alineado} \ operatorname {cov} (X, Y) = {} & \ sigma _ {XY} = \ sum _ {(x, y) \ in S} f (x, y) \ izquierda (x- \ mu _ {X} \ derecha) \ izquierda (y- \ mu _ {Y} \ derecha) \\ [4pt] = {} & (0) (5-6) (8-8.5) + (0.4) (6-6) (8-8.5) + (0.1) (7-6) (8-8.5) + {} \\ [4pt] y (0.3) (5-6) (9-8.5) + (0) (6-6) (9-8.5) + (0.2) (7-6) (9-8.5) \\ [4pt] = {} & {- 0.1} \;. \ End {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8a80fa4db641ca7ddd6f7a3fee8620eed15321a7)

![{\ Displaystyle \ operatorname {E} [XY] = \ operatorname {E} [X] \ cdot \ operatorname {E} [Y].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c0c2870ec57051083bd6262aa4069a2500dfda44)

![[-1,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/51e3b7f14a6f70e614728c583409a0b9a8b9de01)

![{\ displaystyle {\ begin {alineado} \ operatorname {cov} (X, Y) & = \ operatorname {cov} \ left (X, X ^ {2} \ right) \\ & = \ operatorname {E} \ left [X \ cdot X ^ {2} \ right] - \ operatorname {E} [X] \ cdot \ operatorname {E} \ left [X ^ {2} \ right] \\ & = \ operatorname {E} \ left [X ^ {3} \ right] - \ operatorname {E} [X] \ operatorname {E} \ left [X ^ {2} \ right] \\ & = 0-0 \ cdot \ operatorname {E} [X ^ {2}] \\ & = 0. \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/19b6f2d636d5ef9ba85b6350e49222109a28d665)

![{\ displaystyle {\ begin {align} 0 \ leq \ sigma ^ {2} (Z) & = \ operatorname {cov} \ left (X - {\ frac {\ operatorname {cov} (X, Y)} {\ sigma ^ {2} (Y)}} Y, \; X - {\ frac {\ operatorname {cov} (X, Y)} {\ sigma ^ {2} (Y)}} Y \ right) \\ [ 12pt] & = \ sigma ^ {2} (X) - {\ frac {(\ operatorname {cov} (X, Y)) ^ {2}} {\ sigma ^ {2} (Y)}}. \ End {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc8741ab12cb5943efe9d8dbfeb455517bc63347)

![{\ Displaystyle \ textstyle {\ overline {\ mathbf {q}}} = \ left [q_ {jk} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cb28ac928a2a379d039d27fb99d56dd21c1c027c)

![{\ displaystyle {\ begin {alineado} \ operatorname {K} _ {\ mathbf {XX}} = \ operatorname {cov} (\ mathbf {X}, \ mathbf {X}) & = \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ mathrm {T}} \ right] \\ & = \ operatorname {E} \ left [\ mathbf {XX} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf {X}] \ operatorname {E} [\ mathbf {X}] ^ {\ mathrm {T}}. \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/15725714f72a46ffb0686bafdb209260b842ac39)

![{\ Displaystyle {\ begin {alineado} \ operatorname {cov} (\ mathbf {AX}, \ mathbf {AX}) & = \ operatorname {E} \ left [\ mathbf {AX (A} \ mathbf {X)} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf {AX}] \ operatorname {E} \ left [(\ mathbf {A} \ mathbf {X}) ^ {\ mathrm {T }} \ right] \\ & = \ operatorname {E} \ left [\ mathbf {AXX} ^ {\ mathrm {T}} \ mathbf {A} ^ {\ mathrm {T}} \ right] - \ operatorname { E} [\ mathbf {AX}] \ operatorname {E} \ left [\ mathbf {X} ^ {\ mathrm {T}} \ mathbf {A} ^ {\ mathrm {T}} \ right] \\ & = \ mathbf {A} \ operatorname {E} \ left [\ mathbf {XX} ^ {\ mathrm {T}} \ right] \ mathbf {A} ^ {\ mathrm {T}} - \ mathbf {A} \ operatorname {E} [\ mathbf {X}] \ operatorname {E} \ left [\ mathbf {X} ^ {\ mathrm {T}} \ right] \ mathbf {A} ^ {\ mathrm {T}} \\ & = \ mathbf {A} \ left (\ operatorname {E} \ left [\ mathbf {XX} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf {X}] \ operatorname {E } \ left [\ mathbf {X} ^ {\ mathrm {T}} \ right] \ right) \ mathbf {A} ^ {\ mathrm {T}} \\ & = \ mathbf {A} \ Sigma \ mathbf { A} ^ {\ mathrm {T}}. \ End {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c1b2123c32a8acefc209a4f69d571ee1197a8c59)

![{\ Displaystyle {\ begin {alineado} \ operatorname {K} _ {\ mathbf {X} \ mathbf {Y}} = \ operatorname {cov} (\ mathbf {X}, \ mathbf {Y}) & = \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {Y} - \ operatorname {E} [\ mathbf {Y}]) ^ {\ mathrm {T}} \ right] \\ & = \ operatorname {E} \ left [\ mathbf {X} \ mathbf {Y} ^ {\ mathrm {T}} \ right] - \ operatorname {E} [\ mathbf { X}] \ nombre del operador {E} [\ mathbf {Y}] ^ {\ mathrm {T}} \ end {alineado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/99e6f5ef675f7bb826d04f206bd212d14632ab8c)

![\ operatorname {E} [XY] \ approx \ operatorname {E} [X] \ operatorname {E} [Y]](https://wikimedia.org/api/rest_v1/media/math/render/svg/5cc8091d0da21aa8f5a114797ba5113ddf534f69)

![{\ Displaystyle \ operatorname {cov} (X, Y) = \ operatorname {E} \ left [XY \ right] - \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right ]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bdf56a30f7ff1be354713f144bfd02ba949a77f4)

![{\ Displaystyle \ operatorname {E} \ left [XY \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/128f7734bafe2a92d25d3df5fbb614e1d22b2e45)

![{\ Displaystyle \ operatorname {E} \ left [X \ right] \ operatorname {E} \ left [Y \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f05701ae57cc8e32cd812037d7ba5d3d433021d4)