Bandido armado múltiple - Multi-armed bandit

En teoría de la probabilidad y de aprendizaje automático , el problema bandido múltiples brazos (a veces llamado el K - o N armada perpetrados problema bandido ) es un problema en el que un conjunto limitado fija de recursos debe asignar entre las opciones que compiten (alternativos) de una manera que maximiza su ganancia esperada, cuando las propiedades de cada opción se conocen solo parcialmente en el momento de la asignación, y pueden entenderse mejor a medida que pasa el tiempo o al asignar recursos a la elección. Este es un problema clásico de aprendizaje por refuerzo que ejemplifica el dilema de compensación de exploración-explotación. El nombre proviene de imaginar a un jugador en una fila de máquinas tragamonedas (a veces conocidas como " bandidos de un brazo "), que tiene que decidir qué máquinas jugar, cuántas veces jugar cada máquina y en qué orden jugarlas, y si continuar con la máquina actual o probar una máquina diferente. El problema de los bandidos con múltiples brazos también cae dentro de la amplia categoría de programación estocástica .

En el problema, cada máquina proporciona una recompensa aleatoria a partir de una distribución de probabilidad específica de esa máquina, que no se conoce a priori. El objetivo del jugador es maximizar la suma de recompensas obtenidas mediante una secuencia de tirones de palanca. La compensación crucial que enfrenta el jugador en cada prueba es entre la "explotación" de la máquina que tiene la recompensa más alta esperada y la "exploración" para obtener más información sobre las recompensas esperadas de las otras máquinas. La compensación entre exploración y explotación también se enfrenta en el aprendizaje automático . En la práctica, los bandidos con múltiples armas se han utilizado para modelar problemas como la gestión de proyectos de investigación en una gran organización como una fundación científica o una empresa farmacéutica . En las primeras versiones del problema, el jugador comienza sin un conocimiento inicial sobre las máquinas.

Herbert Robbins en 1952, al darse cuenta de la importancia del problema, construyó estrategias de selección de población convergente en "algunos aspectos del diseño secuencial de experimentos". Un teorema, el índice de Gittins , publicado por primera vez por John C. Gittins , proporciona una política óptima para maximizar la recompensa con descuento esperada.

Motivación empírica

El problema de los bandidos de armas múltiples modela un agente que simultáneamente intenta adquirir nuevos conocimientos (llamado "exploración") y optimizar sus decisiones basadas en el conocimiento existente (llamado "explotación"). El agente intenta equilibrar estas tareas en competencia para maximizar su valor total durante el período de tiempo considerado. Hay muchas aplicaciones prácticas del modelo de bandidos, por ejemplo:

- Ensayos clínicos que investiguen los efectos de diferentes tratamientos experimentales mientras se minimizan las pérdidas de pacientes.

- esfuerzos de enrutamiento adaptativo para minimizar los retrasos en una red,

- diseño de cartera financiera

En estos ejemplos prácticos, el problema requiere equilibrar la maximización de la recompensa basada en el conocimiento ya adquirido con el intento de nuevas acciones para aumentar aún más el conocimiento. Esto se conoce como la compensación entre explotación y exploración en el aprendizaje automático .

El modelo también se ha utilizado para controlar la asignación dinámica de recursos a diferentes proyectos, respondiendo a la pregunta de en qué proyecto trabajar, dada la incertidumbre sobre la dificultad y la rentabilidad de cada posibilidad.

Originalmente considerado por los científicos aliados en la Segunda Guerra Mundial , resultó tan intratable que, según Peter Whittle , se propuso que el problema se dejara caer sobre Alemania para que los científicos alemanes también pudieran perder el tiempo en él.

La versión del problema que ahora se analiza comúnmente fue formulada por Herbert Robbins en 1952.

El modelo de bandido de múltiples brazos

El bandido de múltiples brazos (abreviado: bandido o MAB) puede verse como un conjunto de distribuciones reales , cada distribución está asociada con las recompensas entregadas por una de las palancas. Sean los valores medios asociados con estas distribuciones de recompensa. El jugador juega iterativamente una palanca por ronda y observa la recompensa asociada. El objetivo es maximizar la suma de las recompensas recolectadas. El horizonte es el número de rondas que quedan por jugar. El problema de los bandidos es formalmente equivalente a un proceso de decisión de Markov de un solo estado . El arrepentimiento después de las rondas se define como la diferencia esperada entre la suma de recompensas asociada con una estrategia óptima y la suma de las recompensas recolectadas:

,

donde es la recompensa máxima media , y es la recompensa en la ronda t .

Una estrategia de arrepentimiento cero es una estrategia cuyo arrepentimiento promedio por ronda tiende a cero con probabilidad 1 cuando el número de rondas jugadas tiende a infinito. De manera intuitiva, se garantiza que las estrategias sin arrepentimiento converjan en una estrategia óptima (no necesariamente única) si se juegan suficientes rondas.

Variaciones

Una formulación común es el bandido binario de múltiples brazos o el bandido de múltiples brazos de Bernoulli, que emite una recompensa de uno con probabilidad y, de lo contrario, una recompensa de cero.

En otra formulación del bandido de múltiples brazos, cada brazo representa una máquina de Markov independiente. Cada vez que se toca un brazo en particular, el estado de esa máquina avanza a uno nuevo, elegido de acuerdo con las probabilidades de evolución del estado de Markov. Existe una recompensa en función del estado actual de la máquina. En una generalización denominada "problema de los bandidos inquietos", los estados de armas no jugadas también pueden evolucionar con el tiempo. También se ha hablado de sistemas en los que el número de opciones (sobre qué brazo jugar) aumenta con el tiempo.

Los investigadores en ciencias de la computación han estudiado a los bandidos con múltiples brazos bajo las suposiciones del peor de los casos, obteniendo algoritmos para minimizar el arrepentimiento en horizontes de tiempo tanto finitos como infinitos ( asintóticos ) para los pagos de los brazos tanto estocásticos como no estocásticos.

Estrategias de bandidos

Un avance importante fue la construcción de estrategias o políticas de selección de población óptimas (que posean una tasa de convergencia máxima uniforme hacia la población con la media más alta) en el trabajo que se describe a continuación.

Soluciones óptimas

En el artículo "Reglas de asignación adaptativa asintóticamente eficientes", Lai y Robbins (siguiendo los artículos de Robbins y sus colaboradores que se remontan a Robbins en el año 1952) construyeron políticas de selección de población convergente que poseen la tasa de convergencia más rápida (para la población con media más alta) para el caso de que las distribuciones de recompensa de la población sean la familia exponencial de un parámetro. Luego, en Katehakis y Robbins se dieron simplificaciones de la política y la principal prueba para el caso de poblaciones normales con variaciones conocidas. El siguiente avance notable lo obtuvieron Burnetas y Katehakis en el artículo "Políticas adaptativas óptimas para problemas de asignación secuencial", donde se construyeron políticas basadas en índices con tasa de convergencia máxima uniforme, bajo condiciones más generales que incluyen el caso en el que las distribuciones de resultados de cada población depende de un vector de parámetros desconocidos. Burnetas y Katehakis (1996) también proporcionaron una solución explícita para el caso importante en el que las distribuciones de resultados siguen distribuciones discretas, univariadas arbitrarias (es decir, no paramétricas).

Más adelante, en "Políticas de adaptación óptimas para los procesos de decisión de Markov", Burnetas y Katehakis estudiaron el modelo mucho más amplio de los procesos de decisión de Markov con información parcial, donde la ley de transición y / o las recompensas esperadas de un período pueden depender de parámetros desconocidos. En este trabajo, la forma explícita para una clase de políticas adaptativas que poseen propiedades de tasa de convergencia máxima uniforme para la recompensa total esperada del horizonte finito, se construyó bajo supuestos suficientes de espacios finitos de acción estatal y la irreductibilidad de la ley de transición. Una característica principal de estas políticas es que la elección de acciones, en cada estado y período de tiempo, se basa en índices que son inflaciones del lado derecho de las ecuaciones de optimización de recompensa promedio estimadas. Estas inflaciones se han denominado recientemente el enfoque optimista en el trabajo de Tewari y Bartlett, Ortner Filippi, Cappé y Garivier, y Honda y Takemura.

Cuando se utilizan soluciones óptimas para tareas de bandidos con múltiples brazos para derivar el valor de las elecciones de los animales, la actividad de las neuronas en la amígdala y el estriado ventral codifica los valores derivados de estas políticas, y se puede utilizar para decodificar cuándo los animales hacen exploraciones versus elecciones explotadoras. Además, las políticas óptimas predicen mejor el comportamiento de elección de los animales que las estrategias alternativas (descritas a continuación). Esto sugiere que las soluciones óptimas para los problemas de los bandidos con múltiples brazos son biológicamente plausibles, a pesar de ser computacionalmente exigentes.

- UCBC (límites históricos superiores de confianza con clústeres): el algoritmo adapta UCB a un nuevo entorno de modo que pueda incorporar información histórica y de clústeres. El algoritmo incorpora las observaciones históricas utilizando tanto en el cálculo de las recompensas medias observadas como el término de incertidumbre. El algoritmo incorpora la información de agrupamiento jugando en dos niveles: primero seleccionando un grupo usando una estrategia similar a UCB en cada paso de tiempo, y luego eligiendo un brazo dentro del grupo, nuevamente usando una estrategia similar a UCB.

Soluciones aproximadas

Existen muchas estrategias que proporcionan una solución aproximada al problema de los bandidos y se pueden clasificar en las cuatro categorías generales que se detallan a continuación.

Estrategias semi uniformes

Las estrategias semi-uniformes fueron las primeras (y más simples) que se descubrieron para resolver aproximadamente el problema de los bandidos. Todas esas estrategias tienen en común un comportamiento codicioso en el que siempre se tira de la mejor palanca (basada en observaciones anteriores), excepto cuando se toma una acción (uniformemente) aleatoria.

- Estrategia de épsilon codicioso : se selecciona la mejor palanca para una proporción de las pruebas, y una palanca se selecciona al azar (con probabilidad uniforme) para una proporción . Un valor de parámetro típico podría ser , pero esto puede variar ampliamente según las circunstancias y predilecciones.

- Primera estrategia de Epsilon : una fase de exploración pura es seguida de una fase de explotación pura. Para los ensayos en total, la fase de exploración ocupa los ensayos y la fase de explotación los ensayos. Durante la fase de exploración, se selecciona una palanca al azar (con probabilidad uniforme); durante la fase de explotación, siempre se selecciona la mejor palanca.

- Estrategia de disminución de épsilon: similar a la estrategia de épsilon-codicioso, excepto que el valor de disminuye a medida que avanza el experimento, lo que resulta en un comportamiento altamente exploratorio al principio y un comportamiento altamente explotador al final.

- Estrategia adaptativa de épsilon-codicioso basada en diferencias de valor (VDBE) : similar a la estrategia de disminución de épsilon, excepto que épsilon se reduce en función del progreso del aprendizaje en lugar del ajuste manual (Tokic, 2010). Las altas fluctuaciones en las estimaciones de valor conducen a una alta épsilon (alta exploración, baja explotación); fluctuaciones bajas a épsilon bajo (exploración baja, explotación alta). Se pueden lograr mejoras adicionales mediante una selección de acciones ponderadas por softmax en caso de acciones exploratorias (Tokic & Palm, 2011).

- Estrategia adaptativa épsilon-codiciosa basada en conjuntos bayesianos (Epsilon-BMC) : Una estrategia de adaptación épsilon adaptativa para el aprendizaje por refuerzo similar a VBDE, con garantías de convergencia monótona. En este marco, el parámetro épsilon se ve como la expectativa de una distribución posterior que pondera un agente codicioso (que confía plenamente en la recompensa aprendida) y un agente de aprendizaje uniforme (que desconfía de la recompensa aprendida). Este posterior se aproxima utilizando una distribución Beta adecuada bajo el supuesto de normalidad de las recompensas observadas. Para abordar el posible riesgo de disminuir épsilon demasiado rápido, la incertidumbre en la varianza de la recompensa aprendida también se modela y actualiza utilizando un modelo de gamma normal. (Gimelfarb et al., 2019).

- Estrategia contextual-épsilon-codiciosa : similar a la estrategia épsilon-codiciosa, excepto que el valor de se calcula con respecto a la situación en los procesos experimentales, lo que permite que el algoritmo sea sensible al contexto. Se basa en la exploración / explotación dinámica y puede equilibrar adaptativamente los dos aspectos al decidir qué situación es más relevante para la exploración o explotación, lo que resulta en un comportamiento altamente explorador cuando la situación no es crítica y un comportamiento altamente explotador en una situación crítica.

Estrategias de coincidencia de probabilidad

Las estrategias de emparejamiento de probabilidades reflejan la idea de que el número de tirones de una palanca determinada debe coincidir con su probabilidad real de ser la palanca óptima. Las estrategias de emparejamiento de probabilidades también se conocen como muestreo de Thompson o Bandidos Bayesianos, y son sorprendentemente fáciles de implementar si puede tomar muestras desde el posterior para el valor medio de cada alternativa.

Las estrategias de comparación de probabilidades también admiten soluciones a los llamados problemas de bandidos contextuales.

Estrategias de precios

Las estrategias de precios establecen un precio para cada palanca. Por ejemplo, como se ilustra con el algoritmo POKER, el precio puede ser la suma de la recompensa esperada más una estimación de las recompensas futuras adicionales que se obtendrán a través del conocimiento adicional. Siempre se tira de la palanca de mayor precio.

Estrategias con limitaciones éticas

- Behavior Constrained Thompson Sampling (BCTS) : En este artículo, los autores detallan un agente en línea novedoso que aprende un conjunto de restricciones de comportamiento mediante la observación y utiliza estas restricciones aprendidas como guía al tomar decisiones en un entorno en línea mientras sigue siendo reactivo para recompensar la retroalimentación. Para definir a este agente, la solución fue adoptar una extensión novedosa del entorno clásico de bandidos de múltiples brazos contextuales y proporcionar un nuevo algoritmo llamado Behavior Constrained Thompson Sampling (BCTS) que permite el aprendizaje en línea mientras obedece restricciones exógenas. El agente aprende una política restringida que implementa las restricciones de comportamiento observadas demostradas por un agente docente, y luego usa esta política restringida para guiar la exploración y explotación en línea basada en recompensas.

Estas estrategias minimizan la asignación de cualquier paciente a un brazo inferior ( "deber del médico" ). En un caso típico, minimizan los éxitos esperados perdidos (ESL), es decir, el número esperado de resultados favorables que se pasaron por alto debido a la asignación a un brazo más tarde resultó ser inferior. Otra versión minimiza los recursos desperdiciados en cualquier tratamiento inferior y más caro.

Bandido contextual

Una versión particularmente útil del bandido de múltiples brazos es el problema contextual del bandido de múltiples brazos. En este problema, en cada iteración un agente tiene que elegir entre brazos. Antes de tomar la decisión, el agente ve un vector de características d-dimensional (vector de contexto), asociado con la iteración actual. El alumno usa estos vectores de contexto junto con las recompensas de los brazos jugados en el pasado para elegir el brazo que jugará en la iteración actual. Con el tiempo, el objetivo del alumno es recopilar suficiente información sobre cómo los vectores de contexto y las recompensas se relacionan entre sí, de modo que pueda predecir el siguiente mejor brazo para jugar al observar los vectores de características.

Soluciones aproximadas para bandido contextual

Existen muchas estrategias que brindan una solución aproximada al problema de los bandidos contextuales y se pueden clasificar en dos categorías amplias que se detallan a continuación.

Bandidos lineales en línea

- LinUCB (Bound confianza superior) algoritmo : Los autores suponen una dependencia lineal entre la recompensa esperada de una acción y su contexto y modelar el espacio de representación usando un conjunto de predictores lineales.

- Algoritmo LinRel (aprendizaje de refuerzo asociativo lineal) : similar a LinUCB, pero utiliza la descomposición de valores singulares en lugar de la regresión de Ridge para obtener una estimación de la confianza.

- HLINUCBC (LINUCB histórico con agrupaciones) : propuesto en el documento, amplía la idea de LinUCB con información histórica y agrupada.

Bandidos no lineales en línea

- Algoritmo UCBogram : Las funciones de recompensa no lineales se estiman utilizando un estimador constante por partes llamado regresograma en regresión no paramétrica . Luego, se emplea UCB en cada pieza constante. Los refinamientos sucesivos de la partición del espacio de contexto se programan o se eligen de forma adaptativa.

- Algoritmos lineales generalizados : la distribución de recompensas sigue un modelo lineal generalizado, una extensión de los bandidos lineales.

- Algoritmo NeuralBandit : en este algoritmo se entrenan varias redes neuronales para modelar el valor de las recompensas conociendo el contexto, y utiliza un enfoque de múltiples expertos para elegir en línea los parámetros de perceptrones multicapa.

- Algoritmo KernelUCB : una versión kernelizada no lineal de linearUCB, con implementación eficiente y análisis de tiempo finito.

- Bandit Bosque algoritmo : un bosque al azar se construyó y analizó WRT el bosque aleatorio construido conocer la distribución conjunta de los contextos y las recompensas.

- Algoritmo basado en Oracle : el algoritmo reduce el problema de los bandidos contextuales a una serie de problemas de aprendizaje supervisados y no se basa en la suposición de realizabilidad típica de la función de recompensa.

Bandido contextual restringido

- Bandidos atentos al contexto o Bandidos contextuales con contexto restringido : Los autores consideran una formulación novedosa del modelo de bandidos de múltiples brazos, que se denomina bandido contextual con contexto restringido, donde el alumno solo puede acceder a un número limitado de características en cada iteración. Esta novedosa formulación está motivada por diferentes problemas en línea que surgen en ensayos clínicos, sistemas de recomendación y modelado de atención. Aquí, adaptan el algoritmo estándar de bandidos de múltiples brazos conocido como Thompson Sampling para aprovechar la configuración de contexto restringido y proponen dos algoritmos novedosos, llamados Thompson Sampling with Restricted Context (TSRC) y Windows Thompson Sampling with Restricted Context (WTSRC). ), para el manejo de entornos estacionarios y no estacionarios, respectivamente.

En la práctica, generalmente existe un costo asociado con el recurso consumido por cada acción y el costo total está limitado por un presupuesto en muchas aplicaciones como el crowdsourcing y los ensayos clínicos. El bandido contextual restringido (CCB) es un modelo que considera las limitaciones de tiempo y de presupuesto en un entorno de bandidos con múltiples brazos. A. Badanidiyuru y col. Primero estudió a los bandidos contextuales con restricciones presupuestarias, también conocidos como Resourceful Contextual Bandits, y muestra que se puede arrepentir. Sin embargo, su trabajo se centra en un conjunto finito de políticas y el algoritmo es computacionalmente ineficiente.

Se propone un algoritmo simple con arrepentimiento logarítmico en:

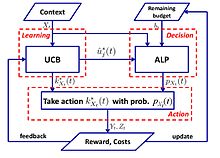

- Algoritmo UCB-ALP : el marco de UCB-ALP se muestra en la figura de la derecha. UCB-ALP es un algoritmo simple que combina el método UCB con un algoritmo de programación lineal adaptativa (ALP) y se puede implementar fácilmente en sistemas prácticos. Es el primer trabajo que muestra cómo lograr arrepentimiento logarítmico en bandidos contextuales restringidos. Aunque está dedicado a un caso especial con restricción de presupuesto único y costo fijo, los resultados arrojan luz sobre el diseño y análisis de algoritmos para problemas CCB más generales.

Bandido adversario

Otra variante del problema de los bandidos con múltiples brazos se llama bandido adversario, introducido por primera vez por Auer y Cesa-Bianchi (1998). En esta variante, en cada iteración, un agente elige un brazo y un adversario elige simultáneamente la estructura de pago para cada brazo. Esta es una de las generalizaciones más fuertes del problema de los bandidos, ya que elimina todas las suposiciones de la distribución y una solución al problema de los bandidos adversarios es una solución generalizada para los problemas más específicos de los bandidos.

Ejemplo: dilema del prisionero iterado

Un ejemplo que se suele considerar para los bandidos adversarios es el dilema del prisionero repetido . En este ejemplo, cada adversario tiene dos brazos para tirar. Pueden negar o confesar. Los algoritmos estándar de bandidos estocásticos no funcionan muy bien con estas iteraciones. Por ejemplo, si el oponente coopera en las primeras 100 rondas, falla en las siguientes 200, luego coopera en las siguientes 300, etc., entonces algoritmos como UCB no podrán reaccionar muy rápidamente a estos cambios. Esto se debe a que, después de cierto punto, rara vez se jalan los brazos subóptimos para limitar la exploración y centrarse en la explotación. Cuando el entorno cambia, el algoritmo no puede adaptarse o ni siquiera puede detectar el cambio.

Soluciones aproximadas

Exp3

Algoritmo

Parameters: Real Initialisation: for For each t = 1, 2, ..., T 1. Set 2. Draw randomly according to the probabilities 3. Receive reward 4. For set:

Explicación

Exp3 elige un brazo al azar con probabilidad , prefiere brazos con pesos más altos (explotación), elige con probabilidad γ para explorar uniformemente al azar. Después de recibir las recompensas, se actualizan los pesos. El crecimiento exponencial aumenta significativamente el peso de los brazos buenos.

Análisis de arrepentimiento

El arrepentimiento (externo) del algoritmo Exp3 es como mucho

Siga el algoritmo de líder perturbado (FPL)

Algoritmo

Parameters: Real Initialisation: For each t = 1,2,...,T 1. For each arm generate a random noise from an exponential distribution 2. Pull arm : Add noise to each arm and pull the one with the highest value 3. Update value: The rest remains the same

Explicación

Seguimos el brazo que creemos que tiene el mejor rendimiento hasta ahora y le agregamos ruido exponencial para proporcionar exploración.

Exp3 vs FPL

| Exp3 | FPL |

|---|---|

| Mantiene los pesos de cada brazo para calcular la probabilidad de tracción | No necesita conocer la probabilidad de tracción por brazo. |

| Tiene garantías teóricas eficientes | El estándar FPL no tiene buenas garantías teóricas |

| Podría ser computacionalmente costoso (calcular los términos exponenciales) | Computacionalmente bastante eficiente |

Bandido de armas infinitas

En la especificación original y en las variantes anteriores, el problema del bandido se especifica con un número de brazos discreto y finito, a menudo indicado por la variable . En el caso de las armas infinitas, introducido por Agrawal (1995), las "armas" son una variable continua en dimensiones.

Bandido no estacionario

Garivier y Moulines obtienen algunos de los primeros resultados con respecto a los problemas de los bandidos donde el modelo subyacente puede cambiar durante el juego. Se presentaron varios algoritmos para tratar este caso, incluidos UCB con descuento y UCB de ventana deslizante.

Otro trabajo de Burtini et al. introduce un método de muestreo de Thompson de mínimos cuadrados ponderados (WLS-TS), que resulta beneficioso tanto en los casos no estacionarios conocidos como en los desconocidos. En el caso no estacionario conocido, los autores producen una solución alternativa, una variante de UCB denominada Límite de confianza superior ajustado (A-UCB) que asume un modelo estocástico y proporciona límites superiores del arrepentimiento.

Otras variantes

En los últimos años se han propuesto muchas variantes del problema.

Bandido en duelo

La variante del bandido en duelo fue introducida por Yue et al. (2012) para modelar la compensación entre exploración y explotación para obtener una retroalimentación relativa. En esta variante, el jugador puede tirar de dos palancas al mismo tiempo, pero solo obtiene una retroalimentación binaria que indica qué palanca proporcionó la mejor recompensa. La dificultad de este problema se debe al hecho de que el jugador no tiene forma de observar directamente la recompensa de sus acciones. Los primeros algoritmos para este problema son InterleaveFiltering, Beat-The-Mean. La retroalimentación relativa de los bandidos en duelo también puede conducir a paradojas en la votación . Una solución es tomar como referencia al ganador de Condorcet .

Más recientemente, los investigadores han generalizado algoritmos desde el MAB tradicional hasta los bandidos en duelo: límites de confianza superior relativos (RUCB), pesaje exponencial relativo (REX3), límites de confianza de Copeland (CCB), divergencia empírica mínima relativa (RMED) y muestreo doble de Thompson (DTS). ).

Bandido colaborativo

Los bandidos de filtrado colaborativo (es decir, COFIBA) fueron presentados por Li y Karatzoglou y Gentile (SIGIR 2016), donde el filtrado colaborativo clásico y los métodos de filtrado basados en contenido intentan aprender un modelo de recomendación estático dados los datos de entrenamiento. Estos enfoques están lejos de ser ideales en dominios de recomendación altamente dinámicos, como la recomendación de noticias y la publicidad computacional, donde el conjunto de elementos y usuarios es muy fluido. En este trabajo, investigan una técnica de agrupación adaptativa para la recomendación de contenido basada en estrategias de exploración-explotación en entornos de bandidos contextuales con múltiples brazos. Su algoritmo (COFIBA, pronunciado como "Coffee Bar") tiene en cuenta los efectos colaborativos que surgen por la interacción de los usuarios con los ítems, agrupando dinámicamente a los usuarios en función de los ítems considerados y, al mismo tiempo, agrupando ítems basado en la similitud de las agrupaciones inducidas sobre los usuarios. El algoritmo resultante aprovecha así los patrones de preferencia en los datos de una manera similar a los métodos de filtrado colaborativo. Proporcionan un análisis empírico sobre conjuntos de datos de tamaño medio del mundo real, que muestran la escalabilidad y un mayor rendimiento de predicción (medido por la tasa de clics) sobre los métodos de vanguardia para agrupar bandidos. También proporcionan un análisis de arrepentimiento dentro de una configuración de ruido estocástico lineal estándar.

Bandido combinatorio

El problema de Combinatorial Multiarmed Bandit (CMAB) surge cuando en lugar de una sola variable discreta para elegir, un agente necesita elegir valores para un conjunto de variables. Suponiendo que cada variable es discreta, el número de opciones posibles por iteración es exponencial en el número de variables. Se han estudiado varias configuraciones CMAB en la literatura, desde configuraciones donde las variables son binarias hasta configuraciones más generales donde cada variable puede tomar un conjunto arbitrario de valores.

Ver también

- Índice de Gittins : una poderosa estrategia general para analizar los problemas de los bandidos.

- Algoritmo codicioso

- Parada óptima

- Teoría de la búsqueda

- Programación estocástica

Referencias

- ^ a b Auer, P .; Cesa-Bianchi, N .; Fischer, P. (2002). "Análisis en tiempo finito del problema del bandido multiarmado" . Aprendizaje automático . 47 (2/3): 235–256. doi : 10.1023 / A: 1013689704352 .

- ^ Katehakis, MN; Veinott, AF (1987). "El problema del bandido de armas múltiples: descomposición y cálculo" . Matemáticas de la investigación operativa . 12 (2): 262–268. doi : 10.1287 / moor.12.2.262 . S2CID 656323 .

- ^ a b c d Gittins, JC (1989), Índices de asignación de bandidos con múltiples brazos , Serie Wiley-Interscience en Sistemas y optimización., Chichester: John Wiley & Sons, Ltd., ISBN 978-0-471-92059-5

- ↑ a b c d Berry, Donald A .; Fristedt, Bert (1985), Problemas de bandidos : asignación secuencial de experimentos , Monografías sobre estadística y probabilidad aplicada, Londres: Chapman & Hall, ISBN 978-0-412-24810-8

- ^ Weber, Richard (1992), "Sobre el índice de Gittins para bandidos con varios brazos", Annals of Applied Probability , 2 (4): 1024-1033, doi : 10.1214 / aoap / 1177005588 , JSTOR 2959678

- ^ Robbins, H. (1952). "Algunos aspectos del diseño secuencial de experimentos" . Boletín de la American Mathematical Society . 58 (5): 527–535. doi : 10.1090 / S0002-9904-1952-09620-8 .

- ^ JC Gittins (1979). "Procesos bandidos e índices de asignación dinámica". Revista de la Royal Statistical Society. Serie B (Metodológica) . 41 (2): 148-177. doi : 10.1111 / j.2517-6161.1979.tb01068.x . JSTOR 2985029 .

- ^ a b Press, William H. (2009), "Las soluciones Bandit proporcionan modelos éticos unificados para ensayos clínicos aleatorios e investigación de efectividad comparativa", Actas de la Academia Nacional de Ciencias , 106 (52): 22387–22392, Bibcode : 2009PNAS. .10622387P , doi : 10.1073 / pnas.0912378106 , PMC 2793317 , PMID 20018711 .

- ^ Prensa (1986)

- ^ Brochu, Eric; Hoffman, Matthew W .; de Freitas, Nando (septiembre de 2010), Asignación de cartera para optimización bayesiana , arXiv : 1009.5419 , Bibcode : 2010arXiv1009.5419B

- ^ Shen, Weiwei; Wang, Jun; Jiang, Yu-Gang; Zha, Hongyuan (2015), "Portfolio Choices with Orthogonal Bandit Learning" , Actas de conferencias conjuntas internacionales sobre inteligencia artificial (IJCAI2015)

- ^ Farias, Vivek F; Ritesh, Madan (2011), "The irrevocable multiarmed bandit problem", Operations Research , 59 (2): 383–399, CiteSeerX 10.1.1.380.6983 , doi : 10.1287 / opre.1100.0891

- ^ Whittle, Peter (1979), "Discusión del artículo del Dr. Gittins", Revista de la Royal Statistical Society , Serie B, 41 (2): 148-177, doi : 10.1111 / j.2517-6161.1979.tb01069.x

- ^ a b Vermorel, Joannes; Mohri, Mehryar (2005), Algoritmos de bandidos de múltiples brazos y evaluación empírica (PDF) , En European Conference on Machine Learning, Springer, págs. 437–448

- ^ Whittle, Peter (1988), "Bandidos inquietos: asignación de actividad en un mundo cambiante", Journal of Applied Probability , 25A : 287-298, doi : 10.2307 / 3214163 , JSTOR 3214163 , MR 0974588

- ↑ Whittle, Peter (1981), "Bandidos que adquieren armas", Annals of Probability , 9 (2): 284-292, doi : 10.1214 / aop / 1176994469

- ^ Auer, P .; Cesa-Bianchi, N .; Freund, Y .; Schapire, RE (2002). "El problema del bandido de brazos múltiples no estocásticos". SIAM J. Comput. 32 (1): 48–77. CiteSeerX 10.1.1.130.158 . doi : 10.1137 / S0097539701398375 .

- ^ Lai, TL; Robbins, H. (1985). "Reglas de asignación adaptativa asintóticamente eficientes" . Avances en Matemática Aplicada . 6 (1): 4-22. doi : 10.1016 / 0196-8858 (85) 90002-8 .

- ^ Katehakis, MN; Robbins, H. (1995). "Elección secuencial de varias poblaciones" . Actas de la Academia Nacional de Ciencias de los Estados Unidos de América . 92 (19): 8584–5. Código Bibliográfico : 1995PNAS ... 92.8584K . doi : 10.1073 / pnas.92.19.8584 . PMC 41010 . PMID 11607577 .

- ^ Burnetas, AN; Katehakis, MN (1996). "Políticas de adaptación óptimas para problemas de asignación secuencial" . Avances en Matemática Aplicada . 17 (2): 122-142. doi : 10.1006 / aama.1996.0007 .

- ^ Burnetas, AN; Katehakis, MN (1997). "Políticas de adaptación óptimas para los procesos de decisión de Markov". Matemáticas. Oper. Res . 22 (1): 222-255. doi : 10.1287 / moor.22.1.222 .

- ^ Tewari, A .; Bartlett, PL (2008). "La programación lineal optimista lamenta logarítmica de los MDP irreductibles" (PDF) . Avances en sistemas de procesamiento de información neuronal . 20 . CiteSeerX 10.1.1.69.5482 .

- ^ Ortner, R. (2010). "Límites de arrepentimiento en línea para los procesos de decisión de Markov con transiciones deterministas". Informática Teórica . 411 (29): 2684–2695. doi : 10.1016 / j.tcs.2010.04.005 .

- ^ Filippi, S. y Cappé, O. y Garivier, A. (2010). "Límites de arrepentimiento en línea para los procesos de decisión de Markov con transiciones deterministas", Comunicación, Control y Computación (Allerton), 48ª Conferencia Anual de Allerton de 2010 , págs. 115-122

- ^ Honda, J .; Takemura, A. (2011). "Una política asintóticamente óptima para modelos de apoyo finitos en el problema de los bandidos con múltiples brazos". Aprendizaje automático . 85 (3): 361–391. arXiv : 0905.2776 . doi : 10.1007 / s10994-011-5257-4 . S2CID 821462 .

- ^ Averbeck, BB (2015). "Teoría de la elección en bandidos, muestreo de información y tareas de forrajeo" . PLOS Biología Computacional . 11 (3): e1004164. Código bibliográfico : 2015PLSCB..11E4164A . doi : 10.1371 / journal.pcbi.1004164 . PMC 4376795 . PMID 25815510 .

- ^ Costa, VD; Averbeck, BB (2019). "Sustratos subcorticales de decisiones de exploración-explotación en primates" . Neurona . 103 (3): 533–535. doi : 10.1016 / j.neuron.2019.05.017 . PMC 6687547 . PMID 31196672 .

- ^ Bouneffouf, D. (2019). Aprovechamiento óptimo de la información histórica y de agrupamiento en clústeres en Multi-Armed Bandit . Actas de la Vigésimo Octava Conferencia Conjunta Internacional sobre Inteligencia Artificial . AAAI. Soc. págs. 270-279. doi : 10.1109 / sfcs.2000.892116 . ISBN 978-0769508504. S2CID 28713091 .

- ^ Sutton, RS & Barto, AG 1998 Aprendizaje por refuerzo: una introducción. Cambridge, MA: MIT Press.

- ^ Tokic, Michel (2010), "Exploración adaptativa ε-codiciosa en el aprendizaje por refuerzo basado en diferencias de valor" (PDF) , KI 2010: Avances en inteligencia artificial , Lecture Notes in Computer Science, 6359 , Springer-Verlag, págs. 203– 210, CiteSeerX 10.1.1.458.464 , doi : 10.1007 / 978-3-642-16111-7_23 , ISBN 978-3-642-16110-0.

- ^ Tokic, Michel; Palm, Günther (2011), "Exploración basada en diferencias de valor: Control adaptativo entre Epsilon-Greedy y Softmax" (PDF) , KI 2011: Avances en inteligencia artificial , Lecture Notes in Computer Science, 7006 , Springer-Verlag, págs. 335 –346, ISBN 978-3-642-24455-1.

- ^ Gimelfarb, Michel; Sanner, Scott; Lee, Chi-Guhn (2019), "ε-BMC: A Bayesian Ensemble Approach to Epsilon-Greedy Exploration in Model-Free Reinforcement Learning" (PDF) , Actas de la trigésima quinta conferencia sobre incertidumbre en inteligencia artificial , AUAI Press, pag. 162 .

- ^ Bouneffouf, D .; Bouzeghoub, A .; Gançarski, AL (2012), "Un algoritmo de bando contextual para un sistema de recomendación móvil sensible al contexto", Procesamiento de información neuronal , Notas de la conferencia en Ciencias de la Computación, 7665 , p. 324, doi : 10.1007 / 978-3-642-34487-9_40 , ISBN 978-3-642-34486-2

- ^ a b Scott, SL (2010), "Una mirada bayesiana moderna al bandido de múltiples brazos", Modelos estocásticos aplicados en los negocios y la industria , 26 (2): 639–658, doi : 10.1002 / asmb.874

- ^ Olivier Chapelle; Lihong Li (2011), "Una evaluación empírica del muestreo de Thompson" , Avances en los sistemas de procesamiento de información neuronal 24 (NIPS) , Curran Associates, 24 : 2249-2257

- ^ Bouneffouf, D. (2018). "Incorporación de restricciones de comportamiento en sistemas de IA en línea". La Trigésima Tercera Conferencia AAAI sobre Inteligencia Artificial (AAAI-19) . AAAI .: 270–279. arXiv : 1809.05720 . https://arxiv.org/abs/1809.05720%7Cyear=2019

- ^ Langford, John; Zhang, Tong (2008), "El algoritmo codicioso de la época para bandidos contextuales con múltiples brazos" , Avances en los sistemas de procesamiento de información neuronal 20 , 20 , Curran Associates, Inc., págs. 817–824

- ^ Lihong Li; Wei Chu; John Langford; Robert E. Schapire (2010), "Un enfoque de bando contextual para la recomendación de artículos de noticias personalizados", Actas de la XIX Conferencia Internacional sobre la World Wide Web (WWW 2010) : 661–670, arXiv : 1003.0146 , Bibcode : 2010arXiv1003.0146L , doi : 10.1145 / 1772690.1772758 , ISBN 9781605587998, S2CID 207178795

- ^ Wei Chu; Lihong Li; Lev Reyzin; Robert E. Schapire (2011), "Bandidos contextuales con funciones de pago lineal" (PDF) , Actas de la 14ª Conferencia Internacional sobre Inteligencia Artificial y Estadísticas (AISTATS) : 208-214

- ^ Auer, P. (2000). "Utilizando límites de confianza superiores para el aprendizaje en línea". Actas 41º Simposio Anual sobre Fundamentos de la Informática . Computación IEEE. Soc. págs. 270-279. doi : 10.1109 / sfcs.2000.892116 . ISBN 978-0769508504. S2CID 28713091 .

- ^ Hong, Tzung-Pei; Song, Wei-Ping; Chiu, Chu-Tien (noviembre de 2011). Agrupación de atributos compuestos evolutivos . 2011 Congreso Internacional sobre Tecnologías y Aplicaciones de la Inteligencia Artificial . IEEE. doi : 10.1109 / taai.2011.59 . ISBN 9781457721748. S2CID 14125100 .

- ^ Explotación óptima de la información histórica y de agrupamiento en multiarmados Bandit .

- ^ Bouneffouf, D. (2019). Aprovechamiento óptimo de la información histórica y de agrupamiento en clústeres en Multi-Armed Bandit . Actas de la Vigésimo Octava Conferencia Conjunta Internacional sobre Inteligencia Artificial . AAAI. Soc. págs. 270-279. doi : 10.1109 / sfcs.2000.892116 . ISBN 978-0769508504. S2CID 28713091 .

- ^ Rigollet, Philippe; Zeevi, Assaf (2010), Bandidos no paramétricos con covariables , Conferencia sobre teoría del aprendizaje, COLT 2010, arXiv : 1003.1630 , Bibcode : 2010arXiv1003.1630R

- ^ Slivkins, Aleksandrs (2011), bandidos contextuales con información de similitud. (PDF) , Conferencia sobre teoría del aprendizaje, COLT 2011

- ^ Perchet, Vianney; Rigollet, Philippe (2013), "The multi-arms bandit problem with covariates", Annals of Statistics , 41 (2): 693–721, arXiv : 1110.6084 , doi : 10.1214 / 13-aos1101 , S2CID 14258665

- ^ Sarah Filippi; Olivier Cappé; Aurélien Garivier; Csaba Szepesvári (2010), "Bandidos paramétricos: el caso lineal generalizado" , Avances en los sistemas de procesamiento de información neuronal 23 (NIPS) , Curran Associates, 23 : 586–594

- ^ Lihong Li; Yu Lu; Dengyong Zhou (2017), "Algoritmos comprobablemente óptimos para bandidos contextuales lineales generalizados" , Actas de la 34a Conferencia Internacional sobre Aprendizaje Automático (ICML) : 2071-2080, arXiv : 1703.00048 , Bibcode : 2017arXiv170300048L

- ^ Kwang-Sung Jun; Aniruddha Bhargava; Robert D. Nowak; Rebecca Willett (2017), "Bandidos lineales generalizados escalables: cálculo y hash en línea" , Advances in Neural Information Processing Systems 30 (NIPS) , Curran Associates, 30 : 99–109, arXiv : 1706.00136 , Bibcode : 2017arXiv170600136J

- ^ Branislav Kveton; Manzil Zaheer; Csaba Szepesvári; Lihong Li; Mohammad Ghavamzadeh; Craig Boutilier (2020), "Exploración aleatoria en bandidos lineales generalizados", Actas de la 23a Conferencia Internacional sobre Inteligencia Artificial y Estadística (AISTATS) , arXiv : 1906.08947 , Bibcode : 2019arXiv190608947K

- ^ Allesiardo, Robin; Féraud, Raphaël; Djallel, Bouneffouf (2014), "A Neural Networks Committee for the Contextual Bandit Problem", Neural Information Processing - 21st International Conference, ICONIP 2014, Malaisia, noviembre 03-06,2014, Proceedings , Lecture Notes in Computer Science , 8834 , Springer , págs. 374–381, arXiv : 1409.8191 , doi : 10.1007 / 978-3-319-12637-1_47 , ISBN 978-3-319-12636-4, S2CID 14155718

- ^ Michal Valko; Nathan Korda; Rémi Munos; Ilias Flaounas; Nello Cristianini (2013), Finite-Time Analysis of Kernelised Contextual Bandits , 29th Conference on Uncertainty in Artificial Intelligence (UAI 2013) y (JFPDA 2013)., ArXiv : 1309.6869 , Bibcode : 2013arXiv1309.6869V

- ^ Féraud, Raphaël; Allesiardo, Robin; Urvoy, Tanguy; Clérot, Fabrice (2016). "Bosque aleatorio para el problema del bandido contextual" . Aistats : 93–101.

- ^ Alekh Agarwal; Daniel J. Hsu; Satyen Kale; John Langford; Lihong Li; Robert E. Schapire (2014), "Domando al monstruo: un algoritmo rápido y simple para bandidos contextuales" , Actas de la 31ª Conferencia Internacional sobre Aprendizaje Automático (ICML) : 1638–1646, arXiv : 1402.0555 , Bibcode : 2014arXiv1402.0555A

- ^ Bandido contextual con contexto restringido, Djallel Bouneffouf, 2017 < https://www.ijcai.org/Proceedings/2017/0203.pdf >

- ^ Badanidiyuru, A .; Langford, J .; Slivkins, A. (2014), "Resourceful context bandits" (PDF) , Actas de la conferencia sobre teoría del aprendizaje (COLT)

- ^ a b Wu, Huasen; Srikant, R .; Liu, Xin; Jiang, Chong (2015), "Algorithms with Logarithmic or Sublinear Regret for Constrained Contextual Bandits" , The 29th Annual Conference on Neural Information Processing Systems (NIPS) , Curran Associates, 28 : 433–441, arXiv : 1504.06937 , Bibcode : 2015arXiv150406937W

- ^ Burtini, Giuseppe, Jason Loeppky y Ramon Lawrence. "Una encuesta sobre el diseño de experimentos en línea con el estocástico bandido de múltiples brazos". preimpresión de arXiv arXiv : 1510.00757 (2015).

- ^ Seldin, Y., Szepesvári, C., Auer, P. y Abbasi-Yadkori, Y., 2012, diciembre. Evaluación y Análisis del Desempeño del Algoritmo EXP3 en Ambientes Estocásticos. En EWRL (págs. 103-116).

- ^ Hutter, M. y Poland, J., 2005. Predicción adaptativa en línea siguiendo al líder perturbado . Journal of Machine Learning Research, 6 (abril), págs. 639–660.

- ^ Agrawal, Rajeev. El problema del bandido armado continuo. SIAM J. de Control y Optimización. 1995.

- ^ UCB con descuento, Levente Kocsis, Csaba Szepesvári, 2006

- ^ Sobre políticas de límite de confianza superior para problemas de bandidos no estacionarios, Garivier y Moulines, 2008 < https://arxiv.org/abs/0805.3415 >

- ^ Mejora de los experimentos de marketing online con bandidos con múltiples brazos a la deriva, Giuseppe Burtini, Jason Loeppky, Ramon Lawrence, 2015 < http://www.scitepress.org/DigitalLibrary/PublicationsDetail.aspx?ID=Dx2xXEB0PJE=&t=1 >

- ^ Bouneffouf, Djallel; Feraud, Raphael (2016), "Problema de bandidos con múltiples brazos con tendencia conocida", Neurocomputing

- ^ a b Yue, Yisong; Broder, Josef; Kleinberg, Robert; Joachims, Thorsten (2012), "El problema de los bandidos en duelo con armas K", Journal of Computer and System Sciences , 78 (5): 1538-1556, CiteSeerX 10.1.1.162.2764 , doi : 10.1016 / j.jcss.2011.12. 028

- ^ Yue, Yisong; Joachims, Thorsten (2011), "Beat the Mean Bandit", Actas de ICML'11

- ^ Urvoy, Tanguy; Clérot, Fabrice; Féraud, Raphaël; Naamane, Sami (2013), "Exploración genérica y bandidos del voto con armas K" (PDF) , Actas de la 30ª Conferencia Internacional sobre Aprendizaje Automático (ICML-13)

- ^ Zoghi, Masrour; Whiteson, Shimon; Munos, Remi; Rijke, Maarten D (2014), "Límite de confianza superior relativo para el problema del bandido en duelo armado de $ K $" (PDF) , Actas de la 31ª Conferencia Internacional sobre Aprendizaje Automático (ICML-14)

- ^ Gajane, Pratik; Urvoy, Tanguy; Clérot, Fabrice (2015), "Un algoritmo de pesaje exponencial relativo para bandidos en duelo basados en utilidades adversas" (PDF) , Actas de la 32ª Conferencia Internacional sobre Aprendizaje Automático (ICML-15)

- ^ Zoghi, Masrour; Karnin, Zohar S; Whiteson, Shimon; Rijke, Maarten D (2015), "Copeland Dueling Bandits", Advances in Neural Information Processing Systems, NIPS'15 , arXiv : 1506.00312 , Bibcode : 2015arXiv150600312Z

- ^ Komiyama, Junpei; Honda, Junya; Kashima, Hisashi; Nakagawa, Hiroshi (2015), "Regret Lower Bound and Optimal Algorithm in Dueling Bandit Problem" (PDF) , Actas de la 28ª Conferencia sobre Teoría del Aprendizaje

- ^ Wu, Huasen; Liu, Xin (2016), "Double Thompson Sampling for Dueling Bandits", La 30ª Conferencia Anual sobre Sistemas de Procesamiento de Información Neural (NIPS) , arXiv : 1604.07101 , Bibcode : 2016arXiv160407101W

- ^ a b Li, Shuai; Alexandros, Karatzoglou; Gentile, Claudio (2016), "Collaborative Filtering Bandits", The 39th International ACM SIGIR Conference on Information Retrieval (SIGIR 2016) , arXiv : 1502.03473 , Bibcode : 2015arXiv150203473L

- ^ Gentile, Claudio; Li, Shuai; Zappella, Giovanni (2014), "Agrupación en línea de bandidos", 31ª Conferencia Internacional sobre Aprendizaje Automático, Journal of Machine Learning Research (ICML 2014) , arXiv : 1401.8257 , Bibcode : 2014arXiv1401.8257G

- ^ Gai, Y .; Krishnamachari, B .; Jain, R. (2010), "Aprendizaje de asignaciones de canales multiusuario en redes de radio cognitivas: una formulación combinatoria de bandidos de múltiples brazos", Simposio IEEE de 2010 sobre nuevas fronteras en el espectro dinámico (PDF) , págs. 1–9

- ^ a b Chen, Wei; Wang, Yajun; Yuan, Yang (2013), "Combinatorial multi-arms bandit: General framework and applications", Actas de la 30ª Conferencia Internacional sobre Aprendizaje Automático (ICML 2013) (PDF) , págs. 151-159

- ^ a b Santiago Ontañón (2017), "Bandidos armados múltiples combinatorios para juegos de estrategia en tiempo real" , Journal of Artificial Intelligence Research , 58 : 665–702, arXiv : 1710.04805 , Bibcode : 2017arXiv171004805O , doi : 10.1613 / jair.5398 , S2CID 8517525

Otras lecturas

| Scholia tiene un perfil de tema para Multi-Arms Bandit . |

- Guha, S .; Munagala, K .; Shi, P. (2010), "Algoritmos de aproximación para problemas de bandidos inquietos", Journal of the ACM , 58 : 1–50, arXiv : 0711.3861 , doi : 10.1145 / 1870103.1870106 , S2CID 1654066

- Dayanik, S .; Powell, W .; Yamazaki, K. (2008), "Políticas de índices para problemas de bandidos descontados con restricciones de disponibilidad", Advances in Applied Probability , 40 (2): 377–400, doi : 10.1239 / aap / 1214950209.

- Powell, Warren B. (2007), "Capítulo 10", Programación dinámica aproximada: Resolviendo las maldiciones de la dimensionalidad , Nueva York: John Wiley and Sons, ISBN 978-0-470-17155-4.

- Robbins, H. (1952), "Algunos aspectos del diseño secuencial de experimentos", Boletín de la American Mathematical Society , 58 (5): 527–535, doi : 10.1090 / S0002-9904-1952-09620-8.

- Sutton, Richard; Barto, Andrew (1998), Aprendizaje por refuerzo , MIT Press, ISBN 978-0-262-19398-6, archivado desde el original el 11 de diciembre de 2013.

- Allesiardo, Robin (2014), "A Neural Networks Committee for the Contextual Bandit Problem", Neural Information Processing - 21st International Conference, ICONIP 2014, Malaisia, noviembre 03-06,2014, Proceedings , Lecture Notes in Computer Science, 8834 , Springer , págs. 374–381, arXiv : 1409.8191 , doi : 10.1007 / 978-3-319-12637-1_47 , ISBN 978-3-319-12636-4, S2CID 14155718.

- Weber, Richard (1992), "Sobre el índice de Gittins para bandidos con varios brazos", Annals of Applied Probability , 2 (4): 1024–1033, doi : 10.1214 / aoap / 1177005588 , JSTOR 2959678.

- Katehakis, M .; C. Derman (1986), "Computación de reglas de asignación secuencial óptimas en ensayos clínicos", Procedimientos estadísticos adaptativos y temas relacionados , Institute of Mathematical Statistics Lecture Notes - Monograph Series, 8 , págs. 29–39, doi : 10.1214 / lnms / 1215540286 , ISBN 978-0-940600-09-6, JSTOR 4355518 .

- Katehakis, M .; AF Veinott, Jr. (1987), "El problema de los bandidos con múltiples brazos: descomposición y cálculo" , Mathematics of Operations Research , 12 (2): 262-268, doi : 10.1287 / moor.12.2.262 , JSTOR 3689689 , S2CID 656323 .

enlaces externos

- MABWiser , implementación de Python de código abierto de estrategias bandit que admite políticas contextuales sin contexto, paramétricas y no paramétricas con capacidad de simulación y paralelización incorporada.

- PyMaBandits , implementación de código abierto de estrategias bandit en Python y Matlab.

- Paquete R contextual y de código abierto que facilita la simulación y evaluación de políticas de bandidos de armas múltiples, tanto contextuales como contextuales.

- bandit.sourceforge.net Proyecto Bandit , implementación de código abierto de estrategias bandit.

- Banditlib , implementación de código abierto de estrategias bandit en C ++.

- Leslie Pack Kaelbling y Michael L. Littman (1996). Explotación versus exploración: el caso de un solo estado .

- Tutorial: Introducción a Bandits: Algoritmos y Teoría. Part1 . Part2 .

- El problema del restaurante de Feynman , un ejemplo clásico (con una respuesta conocida) de la compensación entre explotación y exploración.

- Algoritmos Bandit frente a pruebas AB .

- S. Bubeck y N. Cesa-Bianchi Una encuesta sobre bandidos .

- Una encuesta sobre bandidos contextuales con varios brazos , una encuesta / tutorial para bandidos contextuales.

- Publicación de blog sobre estrategias de bandidos con múltiples brazos, con código Python .

- Tramas animadas e interactivas que ilustran estrategias de equilibrio de exploración / explotación de Epsilon-codicioso, muestreo de Thompson y Upper Confidence Bound.

![{\displaystyle \gamma \in (0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3dc19e2d373af486a2a9fe5dc8c3b749cf5756db)

![{\displaystyle x_{i_{t}}(t)\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/10e3084214036b354d688f29dfdefb9cddf857a4)